컴퓨터 과학에서 파이프라인은 한 데이터 처리 단계의 출력이 다음 단계의 입력으로 이어지는 형태로 연결된 구조를 가리킨다.

데이터 파이프라인의 기본적인 흐름

- 필요 데이터 요구사항 확인, 어떤 데이터를 수집할지 선정

- 데이터가 왜 필요한지, 어느 시점에 수집 할 지 있는지 파악

- 데이터 파이프라인을 구축하기 전에 어떤 데이터를 수집해야 하는지목적과 방향을 정하는 것

- 데이터 수집

- 데이터 전처리 저장

- 데이터 시각화 분석

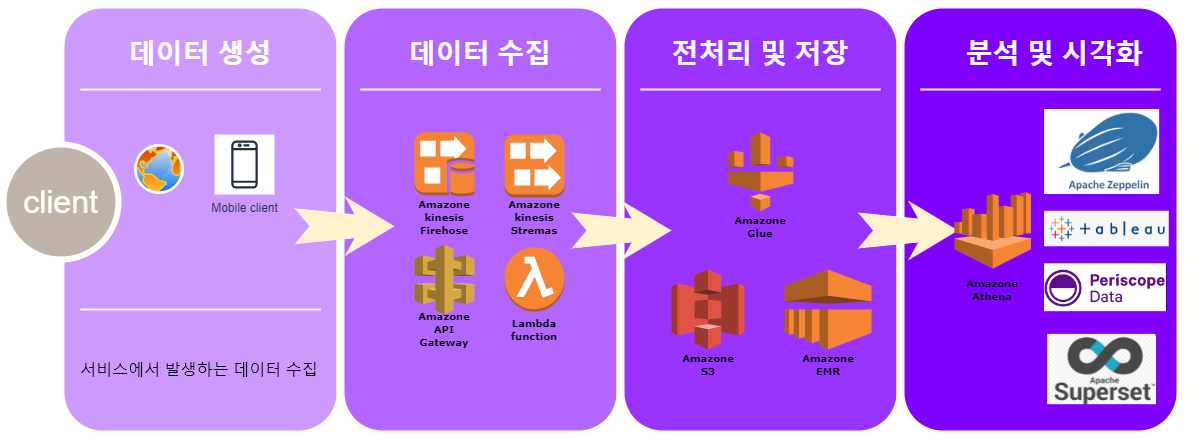

데이터 파이프라인 아키택쳐

아키택쳐 만드는 툴을 이용해 처음으로 만들어봤는데 여간 힘든게 아니다... 하지말까..

아키택쳐에서 쓰이는 서비스들은 따로 공부하면서 업로드 할 예정이다.

데이터 파이프 라인 구성 방안

파이프라인을 설계하기 앞서 고려해야하는 사항

- 회사내의 데이터적 요구사항에 대한 빠른대응

- 하루나 이틀안에 해결 할 수 있는 플랫폼을 추구한다.

- 지속적이고 에러가 없어야 한다.

- 데이터 중심의 회사일수록 에러가 없는것이 중요하다.

- 시스템적으로 발생하는 문제에 대해서 유연한 Scability 해야 한다.

- Scale up과 Scale Out이 자유로워야 한다.

- 클라우드를 사용하기 때문에 비용을 절감하는데 스케일 관리가 유연해야 한다.

- 이벤트성 데이터 부하에도 처리가 가능해야 한다. - 마케팅 이벤트 , 푸시발송, 서비스 오픈 ..

- 예를 들어 신규 오픈일 경우 많은 이벤트로 인한 트래픽이 몰리는 것에 대해 부하처리를 능동적으로 할 수 있어야 한다.

- 데이터 쌓이는 공간에 문제가 없어야 한다.

- 오브젝트 스토리지를 잘 활용하고, S3에 쓰이는 데이터 또한 관리가 되어야한다. - 백업 정책 등

- 수집 데이터(저장 데이터)의 유연성

- 쉬운 분석데이터 Format을 사용한다.

- 대표적으로 JSON 형태

'Development > Data Engineering' 카테고리의 다른 글

| [Apache Spark] 스파크의 구조와 실행흐름 이해하기 (0) | 2022.03.30 |

|---|---|

| 분산처리의 문제점 (0) | 2022.03.23 |

| [Apache Spark] 아파치 스파크 배경, 그리고 이해 (0) | 2022.03.22 |

| 병렬처리와 분산처리 (0) | 2022.03.18 |

| [Apache Kafka] 아파치 카프카란 (0) | 2022.01.05 |

댓글